Nachtrag: Sensoren in mobilen Geräten zur Analyse des persönlichen Status ODER das angeblich „ungenutzte Potential des iPhones“ …

Wir hatten ja nun schon öfters das Thema automatische Sensorsteuerung in mobilen Geräten, nun schlägt jedoch genau in diese Kerbe ein Artikel des MIT Journals Technology Review (TR).

In diesem wird der Hype um das iPhone (mit seinem diversen Sensoren) als Aufhänger genutzt, um ein Konzept des MIT Media Labs vorzustellen: ?Reality Mining?.

Schade, das dieses eigentlich rein wissenschaftliche Magazin so eine Hülle braucht, um ihre Ideen zu kommunizieren … Ok, kommen wir mal zur Kern der Sache:

?Reality Mining? ist im Grund nichts anderes, als das Sammeln von persönlichen Daten über diverse Sensoren und deren Analyse und Darstellung.

Mittelpunkt der Systeme ist neben der Positionsbestimmung durch GPS (oder notfalls Mobilfunk-Zelle) die Auswertung des Bewegungssensors. MIT-Wissenschaftler Nathan Eagle sieht das Potential insbesondere in Verbindung mit sozialen Netzen.

Anhand der Daten des Bewegungssensors kann relativ einfach erkannt werden, ob der Besitzer gerade Fahrrad fährt, sitz oder eine Treppe rauf geht usw. In Verbindung mit weiteren Sensoren (Barometer, Thermometer, Licht, Mikrofon etc.) könnte so ein genaues Tätigkeitsprofil erstellt werden. (Im übrigen ist das System so konzipiert, das über das Mikrofon nicht die Wörter gespeichert werden, sondern nur die Art des Gesprochenen. Also, Taktabstand, Lautstärke, Stimmung, …).

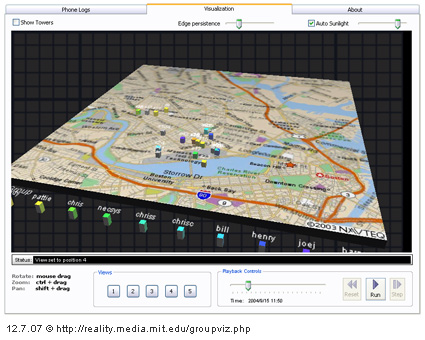

Laut TR, haben Intel-Forscher mit einem solchen System Erstsemestler an der University of Washington ausgestattet und konnten so die Entwicklung der sozialen Netzwerke innerhalb des Semesters ?beobachten?. Am MIT wurden dazu auch diverse Anwendungen entwickelt (die man im Web testen kann), mit der solche gesammelten Daten visualisieren werden können (die Projektseite dazu hier). Ein Beispiel davon ist zum Beispiel die Darstellung, wer wann mit wem in verkehrt hat:

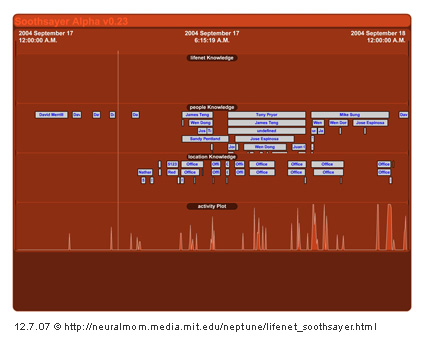

Anhand der Art der Bewegungsdaten kann im übrigen auch immer ein individuelles Tätigkeitsprofil für jeden Nutzer erstellt werden, so das System automatisch mit der Zeit lernt, welche Bewegung z.B. ?essen? bedeuten . So lässt sich dann, beispielsweise ein automatisches Tagebuch generieren:

Kling alles ein wenig beängstigend, nicht wahr? Ich seh? doch schon die Datenschützer die Klagen gegen solche Systeme tippen …

Aber es gibt auch überaus positiv Anwendungen. So könnte in der Altenpflege festgestellt werden ob der Patient regelmäßig ist oder ob dessen Status noch ?Ok? ist, was andernfalls eine Alarmierung auslösen würde.

Bleibt abzuwarten, was sich davon letztendlich durchsetzen wird und für was die iPhone-Sensoren wirklich eines Tages genutzt werden …

Im übrigen hatten wir im Dezember schon mal über ein ähnliches System vom MIT bereichtet, auf das ich gerne noch einmal hinweisen möchte: Real Time Rome

Der ganze (leider nur englische) Technology Review Artikel zum diesem Sensorik-Thema unter:

www.technologyreview.com/Infotech/18990/page1/